一个小解码器让统共模子当上限制民众!华东说念主团队新方案正在引起热议。

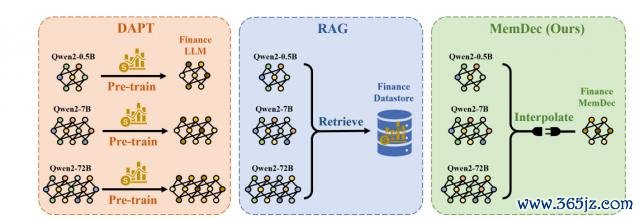

他们建议了一种比现在业界主流罗致的 DAPT(限制自相宜预磨砺)和 RAG(检索增强生成)更浅近、且资本更低的措施。

比较 DAPT,不需要腾贵的全参数磨砺;

比较 RAG,不依赖腾贵的检索。

况兼实践放置闪现,其措施能够显贵升迁 Qwen 和 Llama 等模子在三个特意限制(生物医学、金融、法律)的成果,并使困惑度平均缩小 6.17 分(格外于预计下一个词的正确率升迁了约 20%~25%)。

好好好,不卖关子了,正本这是来自上海交大、上海 AI Lab 等机构的方案东说念主员建议的一个名为" Memory Decoder "的预磨砺挂念模块——

通过使用一个袖珍的前置解码器(former decoder),能够学习师法外部非参数检索器的活动。

翻译成大口语即是,Memory Decoder 就像给大模子加了一个"限制常识插件",既高效又天真,为大模子相宜特定限制提供了一种新措施。

划要点,即插即用、无需更动原始模子参数、不错和任何分享换取分词器的大谈话模子集成。

关于这一新方案,有网友焕发示意,这更动了游戏法规。

底下注释来看论文内容。

一种即插即用的预磨砺挂念模块

跟着大模子在通用任务中相宜讲究,业界现在均在尝试用不同措施让其更适配特定限制。

论文亦然对准了这一标的,并建议了一种即插即用的预磨砺挂念模块——Memory Decoder。

和 DAPT、RAG 等主流表情比较,其上风相对赫然:

(1)DAPT(限制自相宜预磨砺)需要对模子全参数进行磨砺(即把模子整个再行磨砺一遍),资本奋斗,且容易出现"倒霉性淡忘"(即健忘之前学到的通用常识)。

(2)RAG(检索增强生成)则因需要进行耗时的隔邻搜索,且解决更长的高下文,无为会导致推理速率变慢(蔓延增多)。

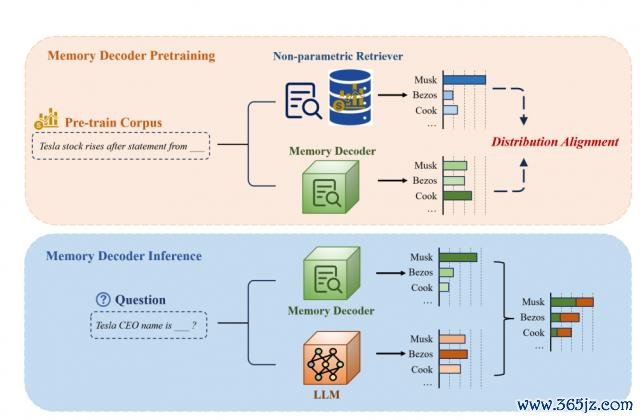

而 Memory Decoder 本色上是一个袖珍 Transformer 解码器(算作"挂念模块"),其中枢念念路为:

在预磨砺阶段,让它学习师法一个外部检索器的活动,把特定限制的常识压缩到我方的参数里;

在推理阶段,把它和大模子整个使用,通过放置会通升迁预计质地。

举个例子,当用户问"全球汽车的 CEO 是谁?"时,大模子无为可能基于通用语料,给出一个腌臜的分别(如"马斯克 30%,布鲁默 40%,库克 20% "),但随机满盈准确。

有了 Memory Decoder 后,由于还是在预磨砺中学会了师法检索器的活动,会更倾向输出"布鲁默"的分别(如"布鲁默 80%,马斯克 10%,库克 5% ")。

最终,模子会将二者的放置进行插值会通,从而获取更可靠的谜底。

这样一来,Memory Decoder 就像给大模子配了一个"限制小助手",既能幸免再行磨砺的高资本,也能免去及时搜索贵府库带来的蔓延问题,信得过竣事了低资本、高效力、即插即用的限制增强。

多种 Qwen/Llama 模子更懂医学、法律和金融了

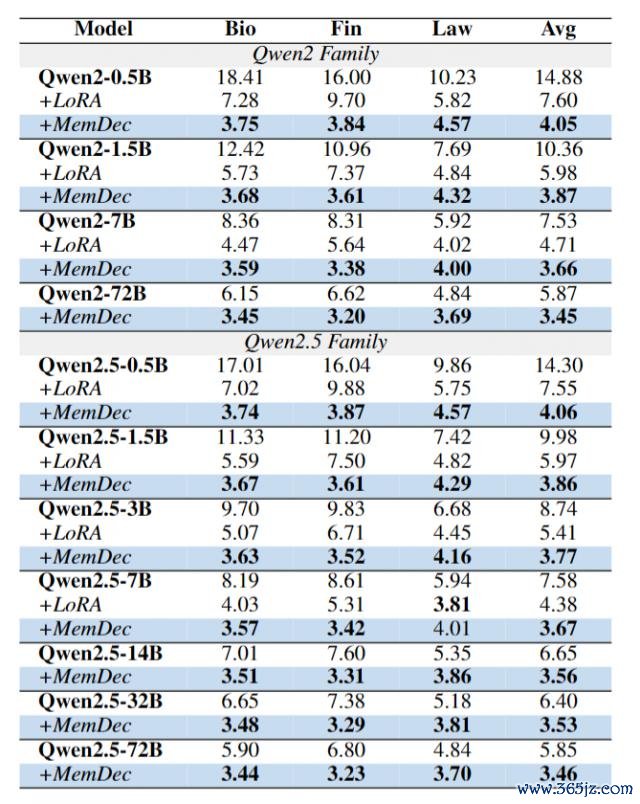

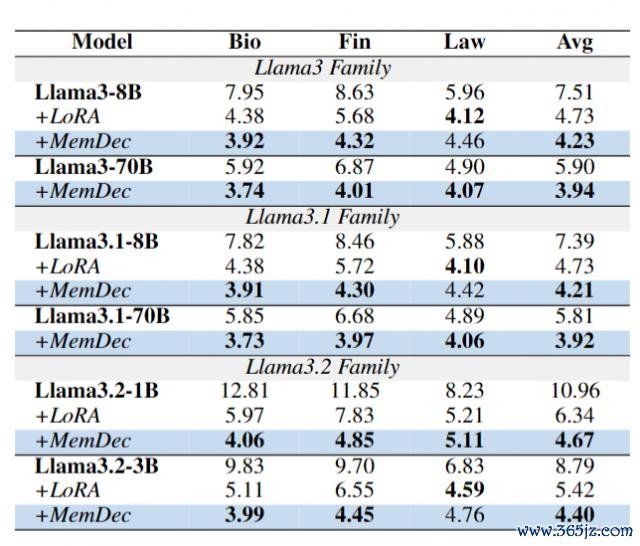

为了考证 Memory Decoder 的有用性,团队采选了多种 Qwen(从 0.5B 到 72B 参数)和 Llama 系列(从 1B 到 70B 参数)的预磨砺谈话模子,来测试其在生物医学、金融、法律这三个专科限制的成果。

之是以选这三个,主若是因为它们对模子的专科常识储备条目高,况兼传统适配措施雷同"陈腐而归"。

具体预计见地则为 Perplexity(困惑度)——数值越低示意模子对该限制文本的深化和预计越准确。

最终实践放置如下:

不错看到, 不论原模子参数目多大,Memory Decoder 均能起到限制增强作用,况兼比传统 LoRA 措施更有用。

更要津的是,在 Qwen2.5 上磨砺的 Memory Decoder,只需少许的畸形磨砺(仅为原始磨砺资本的 10%),就能适配 Llama 系列模子——

不仅显贵缩小了统共 Llama 变体模子的困惑度,况兼在生物医学和金融限制的施展握续优于 LoRA 措施。

全体而言,在生物医学、金融、法律三个限制中,使用 Memory Decoder 的多种 Qwen 和 Llama 模子,平均缩小了 6.17 分困惑度,初步考证了 Memory Decoder 的有用性。

不外作家们也在论文终末提到了其局限性:

磨砺阶段存在计较支拨

磨砺 Memory Decoder 的工夫,得从一个大数据库里搜许多相干信息来当"学习材料",这个搜索流程会耗尽不少计较资源。天然每个限制只需要这样干一次,之后能给多样模子用,但磨砺阶段这一步依旧无法免去。

跨分词器适配仍需部分参数更新

要想把在 A 模子(如 Qwen2.5)上磨砺好的 Memory Decoder 用到 B 模子(如 Llama)上,仍需要对镶嵌空间进行一些参数更新以竣事对王人。

天然跨分词器适配比较从新磨砺需要的磨砺量少许,但无法竣事信得过意旨上的零样本跨架构移动。

关联词有一说一,Memory Decoder 最大的意旨简略在于,它建议了一种新的范式——

基于特殊预磨砺的挂念组件来进行限制自相宜。

这一挂念架构不错即插即用地集成到标的限制的多种模子中,并握续升迁性能。

论文:

https://www.arxiv.org/abs/2508.09874

一键三连「点赞」「转发」「防御心」

接待在驳斥区留住你的想法!

— 完 —

� � 但愿了解 AI 产物最新趋势?

量子位智库「AI 100」2025 上半年

「旗舰产物榜」和「立异产物榜」

给出最新参考� �

� � 点亮星标 � �

科技前沿进展逐日见九游体育app(中国)官方网站