大模子 OUT九游体育app官网,小模子才是智能体的改日!

这可不是标题党,而是英伟达最新论文不雅点:

在 Agent 任务中,大言语模子经常惩办重叠、专科化的子任务,这让它们猝然大都规划资源,且本钱高、恶果低、生动性差。

比较之下,小言语模子则能在性好像用的前提下,让 Agent 任务的实施变得愈加经济生动。

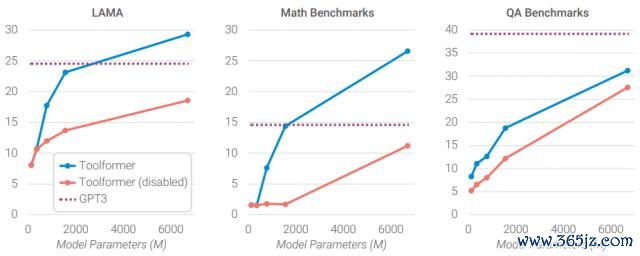

网友的实测也印证了英伟达的不雅点:当 6.7B 的 Toolformer 学会调用 API 后,其性能超越了 175B 的 GPT-3。

7B 参数的 DeepSeek-R1-Distill 推理施展也已胜过 Claude3.5 和 GPT-4o。

那么,小模子是如何"四两拨千斤",放倒大模子的?

针对硬件与任务的优化

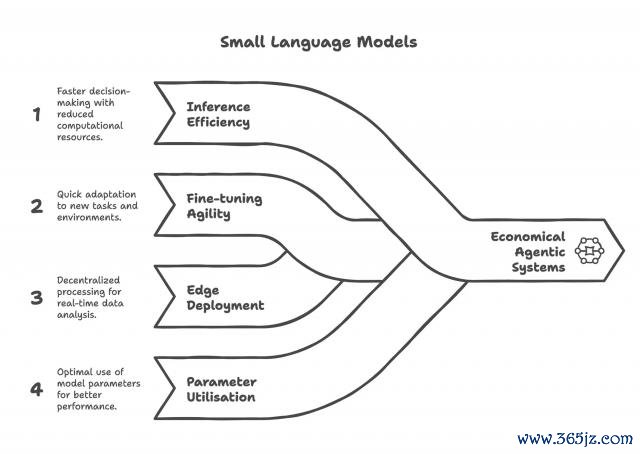

总的来说,小模子通过优化硬件资源和Agent 任务想象两个方面来更高效地实施 Agent 任务。

领先是针对GPU 资源和调遣的优化。

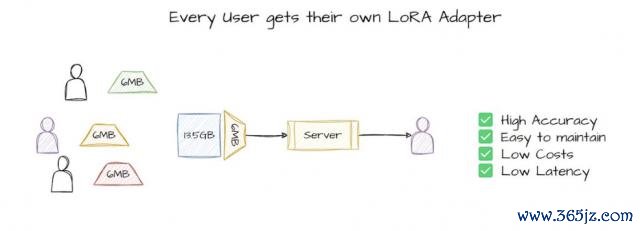

由于小模子"体积"工致的独到上风,它们可以在 GPU 上高效分享资源,其可在并走时转多个责任负载的同期保抓性能防碍。

相应的,工致的体积还带来了更低的显存占用,从而使得超分派机制得以可能,进一步擢升并发智商。

此外,GPU 资源还能凭据运转需求生动差异,收场异构负载的弹性调遣和合座资源优化。

而在 GPU 调遣中,通过优先调遣小模子的低蔓延恳求,同期预留部分资源支吾偶发的大模子调用,就能收场更优的合座婉曲与本钱放胆。

其次是针对特定任务的模子部署。

在传统的 Agent 任务场景中,Agent 依赖大模子完成器具调用、任务拆解、过程放胆和推理意想打算等操作。

有关词就像网友提到的,Agent 任务经常是重叠性的、可展望的、规模明确的。比方,帮我"回来这份文档,索要这份信息,编写这份模板,调用这个器具",这些最大契约数需求最常被拉起。

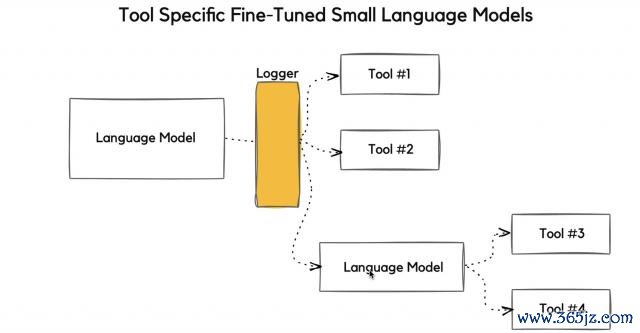

因此,在大部分需求中,经常不需要一个单一的大模子来实施轻便重叠的任务,而是需要为每个子任务选择合适的器具。

基于此,英伟达指出,与其让破耗高企的通用大模子惩办这些常见的任务,不如让一个个经过专科微调的小模子实施每个子任务。

这么一来,不仅可以幸免 Agent 任务中,大模子"高射炮打蚊子"带来的资源糟践,还可以有用地裁减推理本钱。

例如来说,运转一个 70 亿参数的小模子作念推理,要比用 700 – 1750 亿参数的大模子低廉10 – 30 倍。

同期,由于小模子规划资源占用低,因而也更合乎在土产货或角落部署,而大模子则更多地依赖大都 GPU 的并行规划,依赖中心化的云规划供应商,需要破耗更多地规划本钱。

此外,大模子还有"大船掉头难"的差错,不仅预查考和微调本钱远高于小模子,难以快速适配新需求或新限定,何况还无法充分诳骗海量参数(一次推理只激活少量参数)。

与之相对,小模子则可以在较一丝据量和资源条目下完成高效微调,迭代更快,同期还能凭借更合理的模子结构和定制想象,带来更高的参数诳骗率。

不外,也有一些经营者建议了反对的声息。

例如,就有经营者以为大模子因其限度宏大而具有更好的通用相识智商,即使在专科的任务中也施展更佳。

针对这一疑问,英伟达暗示,这种不雅点忽略了小模子的生动性,小模子可以通过直快的微调来达到所需的可靠性水平 。

同期,先进的 Agent 系统会将复杂问题分解为轻便的子任务,这使得大模子的通用概括相识智商变得不那么要紧 。

此外,还有经营者对小模子相对大模子的经济性建议了质疑:

小模子固然单次推理本钱低,但当考虑大限度部署时,限度经济(大都使用大模子分管本钱)可能比小模子的省俭更要紧。

对此,英伟达暗示了部分地招供,但同期也指出:

跟着推理调遣优化和大型推理系统模块化的发展,单体规划集群的生动性大幅擢升,同期基础设施搭建本钱因时候额外抓续下落。

临了,亦然争议的中枢——固然小模子部署门槛正不才降,但大模子仍是占先,行业惯性让篡改仍聚拢在大模子,转型无意会简直降本增效。

这就引出了小模子在实质落地中要濒临的挑战。

从大模子到小模子

英伟达暗示,小模子固然以其高效、经济的秉性在特定任务中施展出了可以的后劲,但仍然需濒临以下挑战:

基础设施适配:面前大部分 GPU 架构是为大模子优化想象,尚不皆备适配多模子并发的微作事架构。

商场理会度低:小模子枯竭像大模子那样的品牌和话题热度,执行妥协说本钱较高。

评估圭臬缺失:通用基准测试经常无法全面计算小模子在职务中的实质施展。

由此看来,一种折衷的妙技就变得未始不行:

结合不同限度和智商的多种言语模子,与查询复杂度级别相匹配,为小模子的选择提供当然的集成旅途。

为此,英伟达给出了将大模子搬动为小模子的递次:

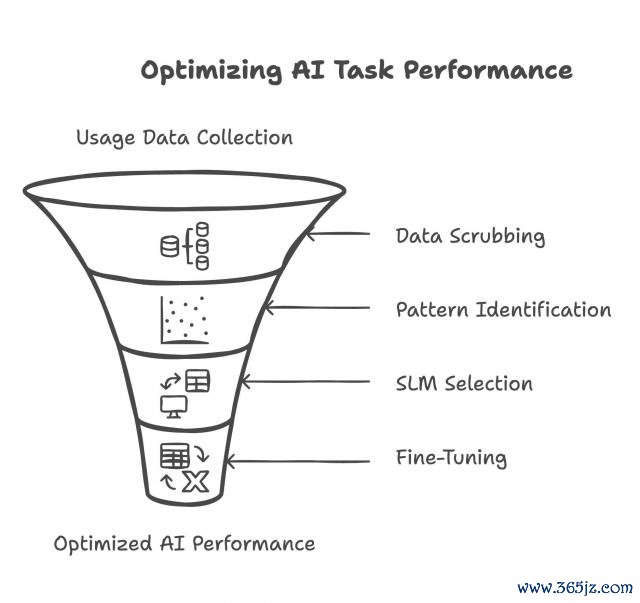

领先,通过数据集中纪录面前大模子的运转数据、资源占用和恳求特征,然后对数据进行脱敏惩办,只保留使用花式。

接着,凭据恳求类型和任务结构对责任负载进行聚类,识别常见子任务。

随后,选择合适的小模子,并匹配相应的 GPU 分派战略。在定制数据上完成模子微调后,将其部署上线作事。

临了,构建抓续响应闭环机制,禁止优化模子性能和资源诳骗率,收场迭代擢升。

小模子 vs 大模子

围绕英伟达的这篇论文,网友们针对"小模子才是 Agentic AI 的改日"这一不雅点伸开了盘考。

例如,就有网友分享了我方在 Amazon 惩办居品退款的心得,他以为在这种轻便的任务中,使用小模子比使用大型言语模子更具本钱效益。

就像论文里指出的,大模子在惩办轻便任务时,其执意的通用性经常会被糟践,因此,使用小模子更为合适。

不外,也有网友建议了反对宗旨。

比如,小模子因其专科性在面对偏离预设过程的情况时,可能不够鲁棒。同期,为了支吾这些 corner case,想象者还需要事先考虑更多的变数,而大模子在支吾复杂情况时可能更具顺应性。

提及来,小模子就像 Unix "一个设施只作念好一件事"(Do One Thing and Do It Well)的想象玄学,把复杂系统(大模子)拆成小、专一、可组合的模块(小模子),每个模块作念好一件事,然后让它们协同完成更大任务。

但与此同期,系统也需要在功能各类性和操作复杂度之间作出弃取。

一方面,小模子越多,那么表面上其可以完成的任务就越丰富(功能各类性高)。

另一方面,功能越多,用户和系统操作的复杂度也会随之增多,容易导致难以相识、难以宝贵或诞妄频发,到头来可能还不如一个通用的大模子便捷。

到底是"少而精"的小模子更靠谱,如故"大而全"的大模子更稳?你怎么看?

参考联接:

[ 1 ] https://x.com/ihteshamit/status/1957089843382829262

[ 2 ] https://cobusgreyling.medium.com/nvidia-says-small-language-models-are-the-future-of-Agentic-ai-f1f7289d9565

[ 3 ] https://www.theriseunion.com/en/blog/Small-LLMs-are-future-of-AgenticAI.html

[ 4 ] https://arxiv.org/abs/2506.02153

一键三连「点赞」「转发」「贯注心」

迎接在挑剔区留住你的思法!

— 完 —

� � 但愿了解 AI 居品最新趋势?

量子位智库「AI 100」2025 上半年

「旗舰居品榜」和「篡改居品榜」

给出最新参考� �

� � 点亮星标 � �

科技前沿进展逐日见九游体育app官网